linux如何让程序运行在多个gpu上

伴随着深度学习算法的快速发展,GPU已经成为了机器学习领域的标配硬件,这也促进了GPU并行计算的研究与应用。然而,在使用多GPU时,如何让程序充分利用GPU资源却是一个非常重要的问题。本文将从不同角度出发,介绍如何让程序运行在多个GPU上,并结合具体案例进行详细解析。

一、使用CUDA库

CUDA是NVIDIA公司推出的一种可以在GPU上实现并行计算的技术。通过使用CUDA库,我们可以在程序中调用CUDAAPI来实现对多个GPU的并行计算。

首先需要检查系统中是否安装了CUDASDK,如果没有安装需要先安装。在程序中使用CUDA库时,需要进行以下几个步骤:

1.初始化所有可用的GPU设备

cudaSetDevice(0);//初始化第一个GPU

cudaSetDevice(1);//初始化第二个GPU

2.在每个设备上分配内存

cudaMalloc((void**)&dev_a,N*sizeof(int));//在第一个设备上分配内存

cudaMalloc((void**)&dev_b,N*sizeof(int));//在第二个设备上分配内存

3.将数据从主机复制到设备

cudaMemcpy(dev_a,a,N*sizeof(int),cudaMemcpyHostToDevice);//将数据从主机复制到第一个设备

cudaMemcpy(dev_b,b,N*sizeof(int),cudaMemcpyHostToDevice);//将数据从主机复制到第二个设备

4.在每个设备上执行计算

add<<<1,N>>>(dev_a,dev_b,dev_c);//在第一个设备上执行计算

add<<<1,N>>>(dev_a,dev_b,dev_c);//在第二个设备上执行计算

5.将结果从设备复制回主机

cudaMemcpy(c,dev_c,N*sizeof(int),cudaMemcpyDeviceToHost);//将结果从第一个设备复制回主机

cudaMemcpy(c,dev_c,N*sizeof(int),cudaMemcpyDeviceToHost);//将结果从第二个设备复制回主机

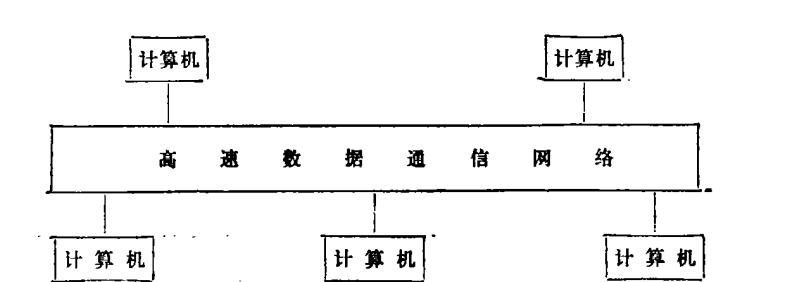

二、使用MPI库

MPI是一种消息传递接口,可以用于在不同节点之间进行通信。通过使用MPI库,我们可以在多个节点上运行程序,并利用每个节点上的GPU资源。

首先需要检查系统中是否安装了MPI库,如果没有安装需要先安装。在程序中使用MPI库时,需要进行以下几个步骤:

1.初始化MPI环境

MPI_Init(&argc,&argv);

2.获取节点数量和当前节点编号

MPI_Comm_size(MPI_COMM_WORLD,&numprocs);

MPI_Comm_rank(MPI_COMM_WORLD,&myid);

3.分配内存并将数据分发到各个节点

if(myid==0){//主节点

for(i=0;i a[i]=i; b[i]=i; } for(i=1;i MPI_Send(a,N,MPI_INT,i,0,MPI_COMM_WORLD); MPI_Send(b,N,MPI_INT,i,0,MPI_COMM_WORLD); } }else{//其他节点 MPI_Recv(a,N,MPI_INT,0,0,MPI_COMM_WORLD,&status);//接收数据 MPI_Recv(b,N,MPI_INT,0,0,MPI_COMM_WORLD,&status); } 4.在每个节点上执行计算 for(i=myid*chunk;i<(myid+1)*chunk;i++){//在当前节点上执行计算 c[i]=a[i]+b[i]; } 5.将结果从各个节点收集到主节点 if(myid!=0){//其他节点将结果发送给主节点 MPI_Send(c+myid*chunk,chunk,MPI_INT,0,myid,MPI_COMM_WORLD); }else{//主节点接收结果并合并 for(i=1;i MPI_Recv(c+i*chunk,chunk,MPI_INT,i,i,MPI_COMM_WORLD,&status); } } 三、使用TensorFlow库 TensorFlow是Google公司开发的一种深度学习框架,可以在多个GPU上进行并行计算。通过使用TensorFlow库,我们可以在程序中调用TensorFlowAPI来实现对多个GPU的并行计算。 首先需要检查系统中是否安装了TensorFlow库,如果没有安装需要先安装。在程序中使用TensorFlow库时,需要进行以下几个步骤: 1.初始化所有可用的GPU设备 withtf.device('/gpu:0'):#初始化第一个GPU a=tf.Variable(tf.random_normal([N])) withtf.device('/gpu:1'):#初始化第二个GPU b=tf.Variable(tf.random_normal([N])) 2.在每个设备上执行计算 withtf.Session()assess: sess.run(tf.global_variables_initializer()) withtf.device('/gpu:0'):#在第一个设备上执行计算 c1=a+b withtf.device('/gpu:1'):#在第二个设备上执行计算 c2=a-b print(sess.run(c1)) print(sess.run(c2)) 以上三种方法都可以让程序充分利用多个GPU资源,但是具体使用哪种方法需要根据实际情况来选择。如果只是简单的并行计算,那么使用CUDA或MPI库可能更加方便;如果是深度学习任务,则可以考虑使用TensorFlow库进行并行计算。 本文通过介绍不同的方法来让程序运行在多个GPU上,并结合具体案例进行详细解析,相信读者已经掌握了相关知识。希望本文能够对读者有所帮助,谢谢! whatsapp最新版:https://cjge-manuscriptcentral.com/software/5779.html